Wie ist der Stand des selbstfahrenden Autos nach 20 Jahren Entwicklung? Eines ist auf jeden Fall klar, „autonom“ fährt es nicht.

Die Evolution der Mobilität

Das Automobil prägt seit über 100 Jahren unsere Mobilität. Am Anfang neben Pferdekutsche, Eisenbahn und Motorrad durchaus belächelt, setzte sich das Automobil nach und nach durch. Es brachte den Menschen die Freiheit, zu jeder Zeit von jedem Ort zu jedem anderen Ort zu reisen. Und das trocken und komfortabel im Vergleich zur Reise mit Pferd oder Kutsche. Heute sind andere Beförderungsmöglichkeiten durchaus schneller. Aber die Möglichkeit, zu jeder Zeit fahren zu können, ist das unschlagbare Argument für das Auto.

Diese individuelle Freiheit möchte heute keiner mehr missen. In Städten mag das Bedürfnis nach dem Auto nicht mehr so groß sein wie auf dem Land. Es ist aber selten ganz verschwunden, auch wenn die Stadt über einen hervorragenden ÖPNV verfügt oder heutzutage das Lastenfahrrad stark an Bedeutung gewinnt.

Entsprechend wird das Auto wohl noch eine ganze Weile zum Straßenbild gehören. Es ist einfach zu praktisch und bequem. Aber ist das Auto überhaupt noch zeitgemäß? Denn auf der anderen Seite ist es das Objekt eines Einzelnen, welches Platz benötigt: sowohl zum Fahren auf der Straße als auch zum Parken. Und um wirklich flexibel oder spontan sein zu können, reicht da ein einziges Auto in der Familie? Meist nicht, wie man heute vielfach beobachten kann.

Aber braucht wirklich jeder ein eigenes Auto? Oder gar mehrere? Diese Fragen sind nicht selten in den letzten Jahren. Bei näherem Hinsehen kann man durchaus zu dem Schluss kommen, dass es nicht um das Auto an sich geht. Es geht um die Dienstleistung, von A nach B zu kommen – mit gewissen Annehmlichkeiten – und um Freiheiten. Gut, für manche ist das Auto ein Statussymbol. Die sind hier nicht gemeint. Es geht vielmehr um die Menschen, die täglich zur Arbeit oder zum Einkaufen fahren und hierfür ein Auto zu Transportzwecken benötigen.

An diesem Punkt kommt für uns das selbstfahrende Auto ins Spiel. Und zwar nicht mehr das eigene, sondern ein Auto, das bei Bedarf in der gewünschten Klasse und am Wunschort zur Verfügung steht. Klar gibt es Car Sharing, aber das allein wird nicht das eigene Auto in voller Gänze ersetzen können. Freiheit und Spontaneität sind wichtig, was Car Sharing nicht uneingeschränkt bieten kann. Nein, wir wollen ein Auto, das auf Knopfdruck kommt – ähnlich wie ein Taxi, aber deutlich billiger. Und genau hier kommt das selbstfahrende Auto ins Spiel.

20 Jahren Entwicklung…

Liest man „20 Jahre“, ist es kaum zu glauben. Aber es stimmt, ADAS-Projekte (Advanced Driver-Assistance Systems) gab es bereits 2004, vielleicht sogar noch früher. Unsere ersten Berührungspunkte lassen sich jedenfalls in dieses Jahr zurückverfolgen. Wie weit ist die Entwicklung heute? Wann endlich gibt es selbstfahrende Autos?

Eine kurze Begriffsklärung: wir vermeiden bewusst den Begriff „autonomes Fahren“. Stattdessen sprechen wir von „selbstfahrend“. Autonom würde bedeuten, dass ein Auto nicht nur selbständig von A nach B fährt, sondern auch entscheidet, ob es überhaupt losfährt oder nicht.

Klassisch bis modern

Die bekannten Lösungen für das Selbstfahren basieren immer auf dem Ansatz: Sensoren messen den Zustand des Autos und dessen Umgebung. Genau wie in der mobilen Robotik. Aus diesem Bereich kommen auch die meisten Algorithmen für die ersten Lösungen des Selbstfahrens. Die Messdaten der Sensoren repräsentieren die Beobachtung dieser Sensoren. Aus den Messdaten wird ein Verständnis der Umgebung und des Zustandes des Autos abgebildet.

Soweit die Gemeinsamkeiten der bekannten Systeme und Entwicklungen. Wir denken, dass dies als grundlegendes Konzept der nächsten Jahre bleiben wird. Wie und welche Messdaten jedoch verarbeitet und interpretiert werden, muss weiter verfeinert und erarbeitet werden, denn die aktuellen Ansätze führen nicht zu einer ausreichenden Qualität bei der Beurteilung der Situation durch das Fahrzeug. Das Ergebnis ist, dass Fahrzeuge eben nicht komplett selbst, sondern „nur“ durch einen Menschen gestützt fahren können.

Für die Lösung des oben genannten Problems gibt aus unserer Sicht verschiedenste Ansätze. Einige Prinzipien und damit verbundene Probleme wollen wir hier anschaulich erklären.

Wie der Mensch sich in der realen Welt bewegt

Ein Mensch kann hören, riechen, sehen und Bewegungen sowie Erschütterungen wahrnehmen. Aus der Kombination dieser Informationen und der über einen langen Zeitraum antrainierten Erfahrung kann er eine bestimmte Verkehrssituation beurteilen.

Diagramm zeigt Zusammenhänge: Laut (Motor und Reifengeräusch) + Bild (Auto) = fahrendes Auto

In diesem Sinne kann auch ein Mensch zu einem Sensor werden und viele heterogene Informationen verarbeiten. Das geschieht meist gemeinsam, simultan, in Interaktionen und mit synergetischen Effekten bis hin zur Suppression. Bei Letzterem sogar unter Unterdrückung von Informationen, was häufig „Fokussierung“ oder im Extremfall auch „Tunnelblick“ genannt wird.

Beim Fahren wird ein Mensch von spezifischen „Erwartungen“ bestimmt: sind diese nicht erfüllt, erfolgt eine Reaktion und die Fahrt wird beendet oder zumindest unterbrochen. Das kann bei ungewohnten Geräuschen oder unerwarteten Wahrnehmungen, abhängig von der Situation erfolgen.

Klassisch:

Messdatenverarbeitung –> Interpretation –> Reaktion

Aber zunächst die Frage: welche Sensoren werden verwendet? Im Automotive-Bereich bietet sich ein Radar an. Denn es soll Autos detektieren, die eigentlich immer irgendwie aus Metall bestehen – ein Material, das ein Radar gut messen kann. Die Umgebung ist meist nicht metallisch und somit gut unterscheidbar von den Autos. Der größte Vorteil des Radars liegt in der geringen Wechselwirkung mit Wasser. Dadurch kann auch bei Regen, Schnee und Nebel ohne signifikante Einschränkungen messen. Jedoch ist eine Größenbestimmung eines beobachteten Objektes nicht ohne Annahmen möglich. Position und Geschwindigkeit können hingegen genau bestimmt werden.

Ein weiterer Sensor ist eine monokulare Kamera (wie eine klassische Webcam). In Verbindung mit Bild-Detektoren (Deep Learning oder klassisch) können Objekte im Kamerabild detektiert werden. Es gibt jedoch eine massive Einschränkung: Eine Kamera ist ein 2D-Sensor, der keine Information über die Tiefe besitzt. Möchte man wissen, wo sich ein Objekt befindet, kann man sich nur mit Annahmen oder mit einem weiteren Sensor behelfen. Aber mit der Kamera können Objekte sehr gut klassifiziert werden. Also um welches Objekt handelt es sich? Haus, Auto, Fußgänger, Radfahrer, etc. Das funktioniert allerdings nicht, wenn die Sicht aufgrund von Regen, Nebel oder Tageszeit eingeschränkt ist.

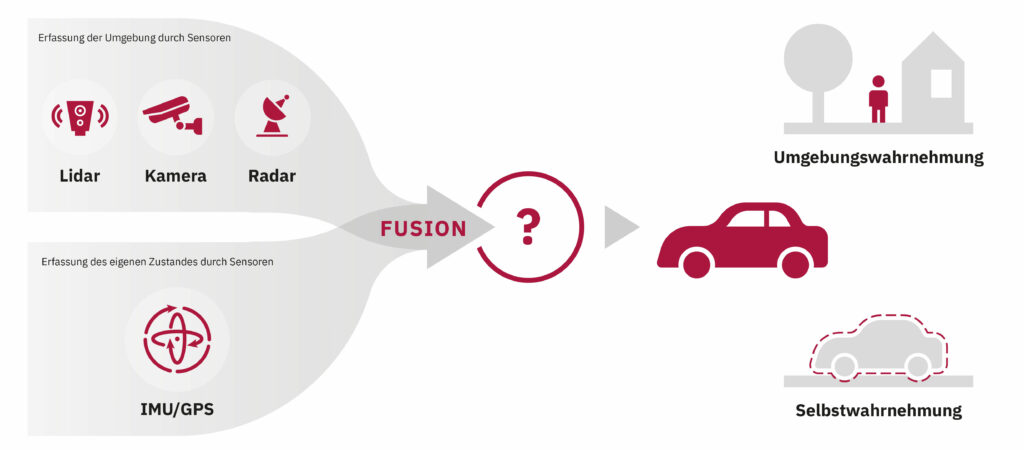

Zu den beiden genannten Sensor-Typen gibt es noch viele andere, wie beispielsweise Lidar zur Messung von 3D-Punktwolken. Alle diese Sensoren dienen zur Erfassung der Umgebung. Zur Messung des eigenen Zustandes – aus Sicht des Automobils – gibt es noch weitere Sensortypen, wie GPS-, Geschwindigkeits- und Beschleunigungs-Sensoren. Wie man sehen kann, ist die Anzahl der verschiedenen Sensoren, mit unterschiedlichen Eigenschaften relativ groß. Jedoch reicht ein Sensor nicht aus, damit ein Fahrzeug dadurch in der Lage ist, selbständig im Straßenverkehr zu fahren.

Aktuell wird daran gearbeitet, verschiedene Sensor-Typen zu fusionieren, um Schwächen von Sensoren mit Stärken anderer Sensoren auszugleichen. Im Grunde nach dem Motto: das Ganze ist mehr als die Summe seiner Einzelteile. Wir möchten hier kurz das Prinzip hinter dieser Fusion erläutern, ohne zu technisch oder physikalisch in der Erklärung zu werden.

Im Kern muss die richtige Ebene gefunden werden, in der die Messungen der Sensoren zusammenkommen. Dies kann auf Sensorebene geschehen, indem die Messungen mit entwickelten technischen Abläufen fusioniert werden. Diese benötigten Abläufe werden so gefunden, indem mit allen verwendeten Sensoren auf dasselbe Objekt geschaut wird. Jeder Sensor-Typ sieht mit seinen Fähigkeiten das Objekt. Somit kann verstanden werden, wie man diese Ansichten zusammenbringt. Diese Fusion vollzieht sich von Sensor zu Sensor, also Messung für Messung. Für uns ist dieser Lösungsansatz jedoch nicht zielführend, weil keine Meta-Information verfügbar ist. Und ohne Meta-Information, denken wir, wird es nicht möglich sein, sogenannte „edge cases“ abzudecken oder überhaupt eine ausreichende Güte zu erreichen.

Eine weitere Möglichkeit ist, die Fusion der Sensoren über ein Modell, das den Zustand der Umgebung mit einer bestimmten Genauigkeit widerspiegelt. Der wesentliche Unterschied zu der erstgenannten Möglichkeit liegt darin, dass die Messung eines einzelnen Sensors gegen dieses Modell fusioniert wird. Eigentlich wird das Modell mit den Messungen korrigiert (updated). Dabei wird nicht die Messung im Modell in irgendeiner Art und Weise abgelegt, sondern es wird die Messung vorher interpretiert. Objekte werden erkannt, oder nur Objekt-Eigenschaften wie Größe, Geschwindigkeit, Orientierung sowie rund oder eckig. Diese Beschreibungen werden dann zu den Objekthypothesen, die in dem Umgebungsmodell gehalten werden, assoziiert.

Aus den gemessenen Daten und eventuell hinterlegten Informationen (beispielsweise eine Straßenkarte) wird versucht, dem Auto ein Verständnis über die Umgebung beizubringen. Dies funktioniert mal mehr oder weniger gut. Es funktioniert jedenfalls nicht ausreichend gut genug.

Probleme sind hier nach wie vor:

- Geometrische Informationen reichen nicht aus, um den komplexen Sachverhalt auf den Straßen abzubilden. Dazu ein einfaches Beispiel: bewegt sich eine Person orthogonal auf die Straße zu, muss eine Vorhersage davon ausgehen, dass die Person auf die Straße laufen wird. Es ist also notwendig, diese Situation zu verstehen.

- Es wird zu Situationen kommen, die nicht explizit programmiert sind. Das Auto muss in diesen Situationen richtig reagieren. Das Auto braucht also nicht nur ein Verständnis der Situation, sondern muss auch sicher aus dieser kommen. Fährt das Auto etwa um ein Hindernis herum, sollte es dabei nicht feststecken. Oder sogar die Insassen gefährden, weil es einen Abhang hinunterfällt.

- Beim selbstfahrenden Auto handelt es sich um eine sicherheitskritische Anwendung, die bestimmte gesetzliche Anforderungen mit sich bringt – zum Glück. Es reicht nicht aus, dass Entwickler durch Probieren einem Auto das Fahren beibringen. Sondern sie müssen auch gegenüber einer Zulassungsstelle begründen können, warum ihre Lösung immer funktionieren wird. Oder zumindest keinem gefährlich werden kann.

KI-Ansatz: Mustererkennung (auf gesamten Messvektor) –> Interpretation –> Reaktion

Einen großen Sprung voran stellen aktuelle Lösungsansätze auf Basis maschinellen Lernens dar. Im Bereich der Umfeldwahrnehmung und Interpretation (nicht nur von Autos) werden spätestens seit 2010 im großen Stil derartige Algorithmen erforscht und bereits in Produkten verwendet. Konkret werden selbstlernende algorithmische Ansätze zur Erkennung (Klassifizierung) von Objekten in Bildern und Videos verwendet. Ein Gesamtsystem zur Umweltwahrnehmung verwendet dabei noch sehr viel mehr als nur einen Algorithmus und einen Sensor und ist daher deutlich komplexer als hier dargestellt. Darüber hinaus ist die Fokussierung auf maschinelles Lernen jedoch in allen mit der Umfeldwahrnehmung verbundenen Disziplinen erkennbar.

Hierbei kann eine Evolution von alleinstehenden „Objekterkennern“, welche aus einzelnen Bildern heraus Objekte isolieren und klassifizieren, hin zu komplexen Algorithmen mit größerer Bandbreite von Eingangsinformationen beobachtet werden.

Die Modelle verwenden in aktuellen Applikationen jedoch immer einen kleinen Ausschnitt der Realität und verarbeiten Informationen als eine Momentbeobachtung der Realität. Auch wenn Ansätze aus den Jahren 2010 bis 2020 bereits komplexere (in Zeit und Raum) Informationen auswerten, bleibt die Wahrnehmung auf lokale Informationen beschränkt. Erst in nachverarbeitenden Schritten, so zum Beispiel in der Bestimmung von freien Bereichen im Nahbereich oder Routen zur Fahrwegberechnung, werden globale Informationen einbezogen.

Die Grenze des Machbaren und darüber hinaus

Aus Produkten, welche heute auf dem Markt für den Kunden verfügbar sind, kann man die Grenzen der aktuellen Ansätze erkennen. So gibt es ein sehr populäres Beispiel, in welchem ein Fahrzeug (Tesla Model 3, das Autopilot System, Juli 2021) den Mond als Ampel erkennt (Ampel mit Phase „gelb“). Da der Mond in Größe und Position auf dem Kamerabild einer Ampel im Zustand der Gelbphase identisch ist – nur der leuchtende Bereich, nicht die Form der Ampel an sich – deutet der “Autopilot” das Objekt als eine Ampel.

Die beschriebene Situation führt sofort dazu, dass dieses System nicht in der Lage ist ein Fahrzeug wirklich selbst Entscheidungen treffen zu lassen. Denn hier handelt es ich um eine sehr einfache für einen Mensch sofort erkennbar Fehlinterpretation. In realen Verkehrssituationen gibt es deutlich schwierige Fälle zu erkennen und zu beurteilen, zu denen dieses System so wie es jetzt funktioniert nicht in der Lage ist.

Warum ist das so?

Mit der Auswertung von Kamerabildern allein kann ein isoliertes System derart komplexe Szenarien nicht interpretieren. Dazu gehören eine Vielzahl an zusätzlichen Metainformationen. Auch ein Mensch kann allein anhand einer bildlichen Form und Farbe eines Objektes nur unzureichend dessen Funktion oder Art erkennen. Ein Mensch nutzt zur Erkennung eine Vielzahl von Metainformationen und ordnet diese Bildinformationen in einen situationsbedingten Kontext ein. Hier ist auch sehr wichtig zu verstehen, dass der Mensch sich nicht zwingendermaßen einen konkreten Ort antrainiert, stattdessen wird aus vorher erlernten Situationen abstrahiert und auf eine neue Situation angewandt. So kann ein Mensch an einem neuen Ort, ohne diesen jemals vorher erlebt zu haben, eine Ampel im Kontext einer Kreuzung (und anderer Informationen) erkennen.

Probleme treten im aktuellen Beispiel für den Autofahrer nur geringfügig auf, da er selbst eingreifen und die falsche Einschätzung der Ampelerkennung übersteuern kann. Jedoch würde dies im Falle selbstfahrender Systeme zu einem gravierenden Fehlverhalten führen, weil das Fahrzeug bei unserem Beispiel mitten auf freier Strecke stehen bleiben könnte, bis der Mond untergegangen oder verdeckt ist.

Unsere These zur Lösung derartiger und noch viel komplexerer Szenarien in der realen Umwelt eines Fahrzeuges ist die folgende: wenn ein Fahrzeug allein Entscheidungen treffen soll, so muss es auch die komplexen Zusammenhänge verstehen und nicht nur ein Bild interpretieren. Entsprechend müssen auch die Algorithmen ein Verständnis der Umwelt erzeugen und nicht nur isolierte Informationen auswerten.

Was fehlt, sind Informationen, die durch wissensbasierte Ansätze wie physikalische Zusammenhänge der Umwelt, vorher erstellte Wissensdatenbanken, physikalische Modelle und durch zusätzliche Arten von Sensoren bereitgestellt werden.

Aus unserer Sicht ist die Anzahl an notwendigen Informationen nicht innerhalb einer einzelnen Systementwicklung erzeugbar und bereitstellbar. Es gibt jedoch andere Möglichkeiten diese Informationen zu generieren und in ein System zu integrieren. Man darf nicht vergessen, dass derart selbstfahrende Systeme sicher im Sinne von gesetzlichen Sicherheitsanforderungen sein müssen, um nicht andere Teilnehmer oder die Insassen selbst im Straßenverkehr zu gefährden.

Hierzu haben wir konzeptionelle Ansätze, die wir in zukünftigen Artikeln beschreiben wollen.

Links:

Tesla autopilot tricked by yellow moon into thinking yellow traffic light – TechStory

https://twitter.com/i/status/1418413307862585344

Andere lernen auch, aber Konzepte sind weiter “isoliert”:

https://www.golem.de/news/autonomes-fahren-musk-haelt-neue-fsd-version-fuer-nicht-besonders-gelungen-2108-159086.html

Autoren: Marcel Brückner und Christian Wendt